우노

[DL] Landmark Detecting 본문

Landmark Detecting

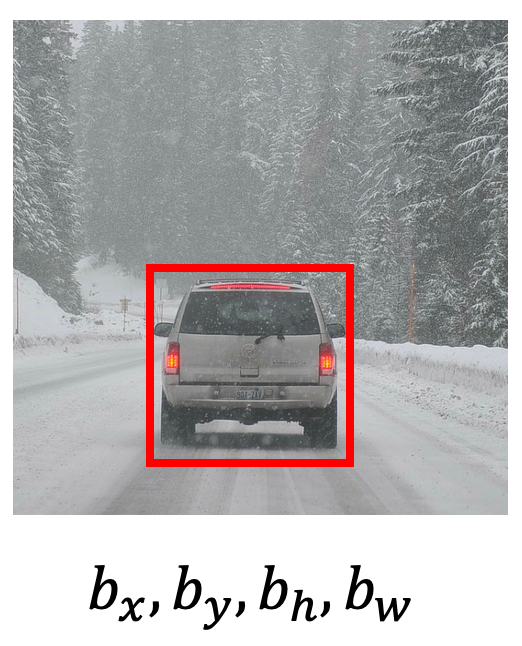

- 이미지가 주어졌을 때, 이미지 내 객체의 위치를 Bounding Box(bx, by, bh, bw)로 출력하는 방법을 Object Localization 이라고 합니다.

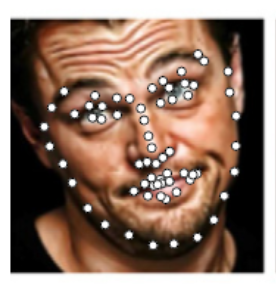

- 또한, 이미지가 주어졌을 때, 이미지 내 객체의 주요 지점을 X, Y 좌표로 출력하는 방법도 있습니다.

- 이를 Landmark Detecting이라고 합니다.

Target Label y 예시 1

- 얼굴로부터 감정을 인식하고 싶다고 가정해봅시다.

- 또한, 이미지가 주어졌을 때, 눈의 가장자리, 코의 가장자리, 입의 가장자리, 턱의 가장자리 등

- 얼굴을 인식할 수 있는 64개의 지점, 즉 64개의 Landmark가 있다고 가정해봅시다.

- 이 때, 각각의 Landmark는 X, Y 좌표를 가질 것입니다.

- 첫 번째 Landmark의 X, Y 좌표는 L_x1, L_y1

- 두 번 째 Landmark의 X, Y 좌표는 L_x2, L_y2

- 64개의 Landmark를 나열하면 [ L_x1, L_y1, L_x2, L_y2, ..., L_x64, L_y64 ] 로 총 128개가 될 것입니다.

- 이 때, 각각의 Landmark는 X, Y 좌표를 가질 것입니다.

- 따라서, Target Label y는 face(얼굴인지 아닌지 여부)와 Landmark의 나열로 이루어질 수 있습니다.

- 구체적으로 보면, 위 예시를 기준으로 [ face, L_x1, L_y1, L_x2, L_y2, ..., L_x64, L_y64 ] 가 됩니다.

- 즉, 129개의 아웃풋 유닛을 가지게 될 것입니다.

Target Label y 예시 2

동작을 인식하고 싶다고 가정해봅시다.

또한, 이미지가 주어졌을 때, 가슴의 중간지점, 왼쪽 어깨, 오른쪽 어깨, 왼쪽 무릎, 오른쪽 무릎 등

포즈를 인식할 수 있는 32개의 지점, 즉 32개의 Landmark가 있다고 가정해봅시다.

- 이 때, 각각의 Landmark는 X, Y 좌표를 가질 것입니다.

- 첫 번째 Landmark의 X, Y 좌표는 L_x1, L_y1

- 두 번 째 Landmark의 X, Y 좌표는 L_x2, L_y2

- 32개의 Landmark를 나열하면 [ L_x1, L_y1, L_x2, L_y2, ..., L_x32, L_y32 ] 로 총 64개가 될 것입니다.

- 이 때, 각각의 Landmark는 X, Y 좌표를 가질 것입니다.

따라서, Target Label y는 pose(동작이 맞는지)와 Landmark의 나열로 이루어질 수 있습니다.

- 구체적으로 보면, 위 예시를 기준으로 [ pose, L_x1, L_y1, L_x2, L_y2, ..., L_x32, L_y32 ] 가 됩니다.

- 즉, 65개의 아웃풋 유닛을 가지게 될 것입니다.

물론, 위와 같은 네트워크를 다루기 위해서는 Training Set Label에도 일일이 Landmark를 달아줘야합니다.

'AI > Deep Learning' 카테고리의 다른 글

| [DL] One Shot Learning, Siamese Network, Triplet Loss, Binary Loss (1) | 2021.02.10 |

|---|---|

| [DL] Object Detection (Sliding Windows, YOLO) (1) | 2021.02.10 |

| [DL] Object Localization (객체 위치 식별) (3) | 2021.02.09 |

| [DL] Convolution, Padding, Stride, Pooling in CNN (1) | 2021.02.03 |

| [DL] LeNet-5, AlexNet, VGG-16, ResNet, Inception Network (1) | 2021.02.03 |

Comments